« LocalAI Assistant à base de modèles IA » : différence entre les versions

m Ajout modèle Guide |

m →Mise à jour des images : Retrait ":" dans les titres |

||

| (41 versions intermédiaires par 2 utilisateurs non affichées) | |||

| Ligne 3 : | Ligne 3 : | ||

== Introduction == | == Introduction == | ||

Je vais vous présenter l'installation d'une instance pour | Je vais vous présenter l'installation d'une instance pour bénéficier d'un assistant personnel basé sur des modèles neuronaux libres ou avec quelques conditions en local. | ||

Pour cela nous utiliserons LocalAI qui est une | Pour cela nous utiliserons <app>LocalAI</app> qui est une API REST alternative open source à <app>OpenAI</app> : https://localai.io/ | ||

Vous pouvez déployer la solution directement, dans un container | Vous pouvez déployer la solution directement sur votre système, dans un container <app>Podman</app>/<app>Docker</app> ou sur un cluster <app>Kubernetes</app>. | ||

Cette documentation s'attardera à présenter une installation dans des containers Podman : | Cette documentation s'attardera à présenter une installation dans des containers avec <app>Podman</app> : https://podman.io/ | ||

Cela parle aussi de l'intégration avec | Cela parle aussi de l'intégration avec votre serveur <app>Nextcloud</app> à partir de la version '''Hub 8''' ('''29.x''') : https://nextcloud.com/fr/ | ||

Nous n'utiliserons qu'une seule instance sur un simple | Nous n'utiliserons qu'une seule instance sur un simple nœud (1 machine physique ou virtuelle), mais il est possible d'en utiliser plusieurs pour du calcul en parallèle. | ||

== Présentation == | == Présentation == | ||

<app>LocalAI</app> permet d'avoir une solution locale pour la mise à disposition et l’exploitation de modèles d’'''Intelligence Artificielle''' ('''IA''' ou '''AI''' en anglais) en local (pas de connexion Internet possible), généralement libre et/ou avec quelques conditions. | |||

Parmi les modèles et options proposés vous pouvez disposer : | Parmi les modèles et options proposés vous pouvez disposer : | ||

* De tchats (Conversationnels + Traducteurs multi-lingues) | |||

* De générateurs d'Images | |||

* De convertisseurs Vidéo/Musique vers du Texte | |||

* De convertisseurs Texte vers Voix | |||

* '''''Et bien d'autres possibilités présentes et à venir...''''' | |||

== Pré-Requis == | |||

Nous vous conseillons de bien régler les paramètres de votre bios et de ne pas utiliser les modes d'overclocking automatique, ainsi que les modes de "boost" du processeur, ainsi que de la carte graphique. Les performances ne sont pas trop impactées et vous allez gagner en consommation/température, mais aussi en silence de fonctionnement. | |||

N'hésitez pas à demander de l'aide sur notre forum si nécessaire. | |||

=== Au minimum | === Au minimum === | ||

* Processeur 4 cœurs/ | * Processeur 4 cœurs/4 threads | ||

* Un bon refroidissement | * Un bon refroidissement | ||

* 16 Go de Mémoire (RAM) | * 16 Go de Mémoire (RAM) | ||

* | * 100 Go de stockage disponible (les modèles prennent beaucoup de place) | ||

=== Conseillé | === Conseillé === | ||

* Processeur | * Processeur 6 cœurs/12 threads | ||

* | * 32, voire 64 Go de Mémoire (RAM) | ||

* | * 500 Go de stockage (NVME de préférence) | ||

=== En option | === En option === | ||

* Carte graphique supportant le GPGPU avec CUDA (Nvidia), ROCM (AMD), SYCL (INTEL) | * Carte graphique supportant le [https://fr.wikipedia.org/wiki/General-Purpose_Processing_on_Graphics_Processing_Units GPGPU] avec [https://fr.wikipedia.org/wiki/CUDA CUDA] (Nvidia), [https://en.wikipedia.org/wiki/Rocm ROCM] (AMD), [https://en.wikipedia.org/wiki/SYCL SYCL] (INTEL) | ||

* Un | * Un [https://fr.wikipedia.org/wiki/Puce_d%27acc%C3%A9l%C3%A9ration_de_r%C3%A9seaux_de_neurones NPU] | ||

* '''''Autres à suivre''''' | * '''''Autres à suivre''''' | ||

== Podman == | == Podman == | ||

=== Installation | === Installation === | ||

==== Accélération CPU | ==== Accélération CPU (réalisé et testé sur AMD Ryzen ZEN3 5600G et 5800X) ==== | ||

On ouvrira les flux du pare feu pour les accès distants sur | On ouvrira les flux du pare-feu pour les accès distants sur les ports '''8082/TCP''' et '''3333/TCP''' : | ||

# firewall-cmd --add-port=8082/tcp --add-port=3333/tcp && firewall-cmd --runtime-to-permanent | # firewall-cmd --add-port=8082/tcp --add-port=3333/tcp && firewall-cmd --runtime-to-permanent | ||

On | |||

On installe <app>podman</app> si ce n'est pas déjà fait : | |||

# dnf install podman | # dnf install podman | ||

On récupère le container de | |||

On récupère le container de <app>localai</app> pour processeur : | |||

$ podman pull docker.io/localai/localai:latest-aio-cpu | $ podman pull docker.io/localai/localai:latest-aio-cpu | ||

On | |||

On va créer un répertoire de stockage permanent (à modifier au besoin) : | |||

$ mkdir ~/projets/IA/models | $ mkdir ~/projets/IA/models | ||

On | |||

$ sudo semanage fcontext -a -e /var/lib/containers /home/'''UTILISATEUR'''/projets/IA/models | On va lui attribuer l'étiquette <app>SELinux</app> du dossier <path>/var/lib/containers</path> '''''(à revoir, car cela ne rend pas le dossier accessible pour les containers sur Fedora 40...)''''' : | ||

$ sudo semanage fcontext -a -e /var/lib/containers /home/'''UTILISATEUR'''/'''projets/IA/models''' | |||

On lance notre container : | On lance notre container : | ||

$ podman run -d --security-opt label=disable -p '''8082''':8080 -p '''3333''':3333 -e GRPC_PORT='''3333''' -e MODELS_PATH=/build/models -v ~/projets/IA/models:/build/models -e LOCALAI_THREADS='''6''' -e LOCALAI_CONTEXT_SIZE='''2048''' -e LOCALAI_UPLOAD_LIMIT='''100''' --name '''test''' docker.io/localai/localai:latest-aio-cpu | $ podman run -d '''--security-opt label=disable''' -p '''8082''':8080 -p '''3333''':3333 -e GRPC_PORT='''3333''' -e MODELS_PATH=/build/models -v '''~/projets/IA/models''':/build/models -e LOCALAI_THREADS='''6''' -e LOCALAI_CONTEXT_SIZE='''2048''' -e LOCALAI_UPLOAD_LIMIT='''100''' --name '''test''' docker.io/localai/localai:latest-aio-cpu | ||

Descriptif des options à modifier au besoin : | Descriptif des options à modifier au besoin : | ||

* '''''LOCALAI_THREADS''''' : Indique le nombre de cœurs/threads à utiliser ('''de préférence n'utiliser que des cœurs physique'''). Ici pour un Ryzen 5 en 6 cœurs/12 threads ('''4 threads par défaut''') | |||

* '''''LOCALAI_CONTEXT_SIZE''''' (en Méga octets) : Définit la taille du contexte des modèles ('''512 Mo par défaut'''). Ici réglé sur '''2048 Mo''' | |||

* '''''LOCALAI_UPLOAD_LIMIT''''' (en Méga octets) : Limite de téléchargement ('''15 Mo par défaut'''). Ici réglé sur '''100 Mo''' | |||

==== Accélération CPU+GPU ROCM (AMD) ==== | |||

A venir | |||

==== Accélération CPU+GPU CUDA (NVIDIA) ==== | |||

A venir | |||

==== Accélération CPU+GPU SYCL (INTEL) ==== | |||

A venir | |||

=== Utilisation === | |||

==== | ==== Par l'interface graphique Web ==== | ||

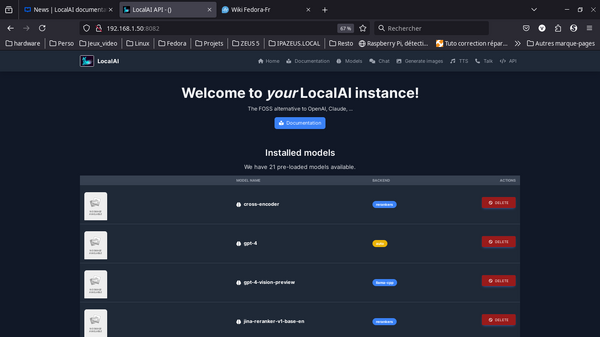

Pour accéder à l'interface graphique depuis un navigateur Web, il faut utiliser le lien : | |||

http://<IPmachine>:8082 | |||

ou | |||

http://localhost:8082 | |||

Il est nécessaire de bien sélectionner son modèle avant de l'utiliser (exemple : génération d'image avec "stable diffusion", etc) | |||

==== | ===== Accueil ===== | ||

[[Fichier:Accueil-WebUI-LocalAI.png|centré|vignette|600px]] | |||

===== | ===== Models ===== | ||

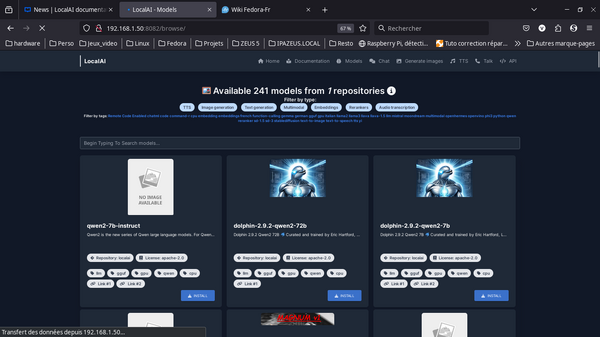

La liste des modèles peut être consultée ('''en anglais''') soit sur cette page, soit sur le site : https://localai.io/gallery.html . | |||

Vous en avez beaucoup de disponibles, censurées ou non. Il faut consulter le descriptif en anglais pour savoir si cela vous convient. | |||

Il y en a d'autres à installer manuellement, voir pour cela sur le site de LocalAI. | |||

[[Fichier:Models-WebUI-LocalAI.png|centré|vignette|600px]] | |||

===== | ===== Chat ===== | ||

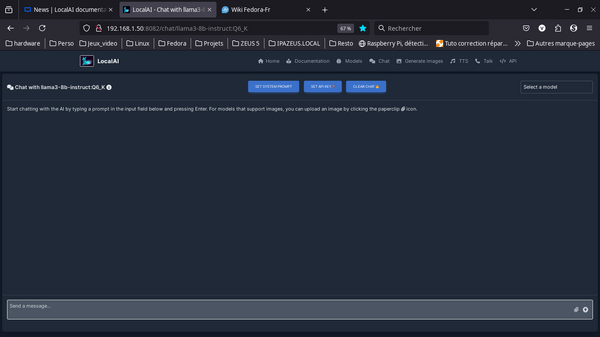

Il faut choisir le modèle pour pouvoir converser avec ; la liste ne fait pas la distinction. | |||

Exemple de modèles '''"GPT4" (par défaut)''' ou '''llama3-8b-instruct''' ('''à installer''', bon rapport performance/qualité dans les interactions). | |||

[[Fichier:Tchat-WebUI-LocalAI.png|centré|vignette|600px]] | |||

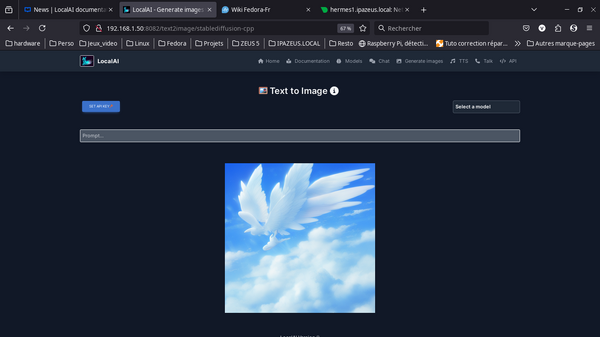

===== | ===== Generate images ===== | ||

[[Fichier:Images-WebUI-LocalAI.png|centré|vignette|600px|Modèle utilisé "stablediffusion"]] | |||

==== | ===== TTS ===== | ||

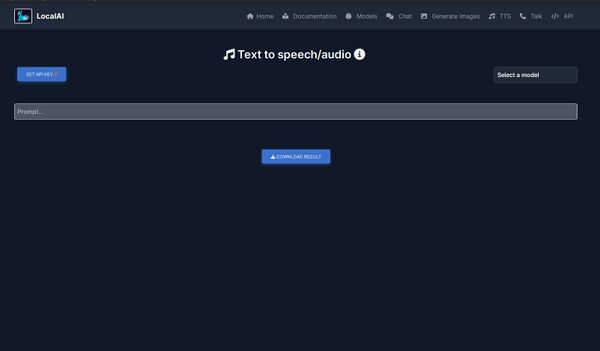

[[Fichier:LocalAI TTS.jpg|centré|vignette|600px|Modèle utilisé "voice-fr-gilles-low"]] | |||

===== | ===== Talk ===== | ||

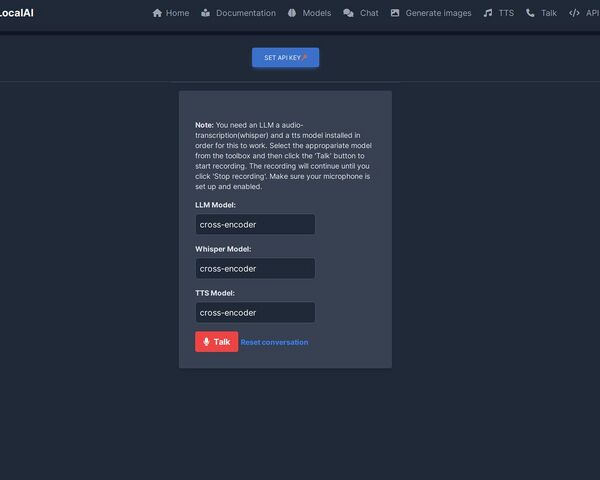

[[Fichier:LocalAI Talk.jpg|centré|vignette|600px]] | |||

===== | ===== </>API ===== | ||

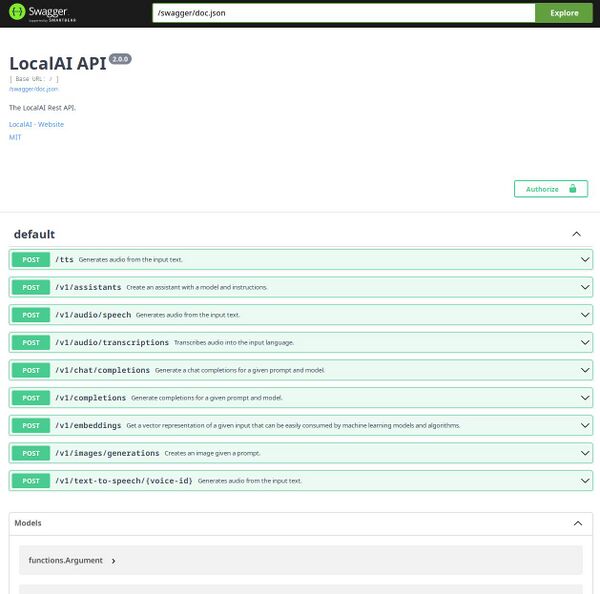

[[Fichier:LocalAI API.jpg|centré|vignette|600px]] | |||

==== | ==== En ligne de commande ==== | ||

Voici quelques exemples et résultats selon les cas d'utilisation. Les exemples sont généralement tirés de ceux de "localAI" avec les liens directs. | |||

La liste des modèles installés disponibles s'obtient avec : | |||

$ curl http://'''<IP-Machine>''':'''8082'''/v1/models | |||

===== Chat ===== | |||

Exemple : | |||

$ curl http://'''<IP-Machine>''':'''8082'''/v1/chat/completions -H "Content-Type: application/json" -d '{ | |||

"model": "'''llama3-8b-instruct'''", | |||

"messages": [{"role": "user", "content": "'''Salut, comment vas tu?'''"}], | |||

"temperature": '''0.1''' | |||

}' | |||

Réponse : | |||

{"created":1720598309,"object":"chat.completion","id":"'''xxxxxxx-a24f-xxxxxxx-a0de-xxxxxxxxxdeb'''","model":"'''llama3-8b-instruct'''","choices":[{"index":0,"finish_reason":"stop","message":{"role":"assistant","content":"'''''Bonjour ! Je suis un modèle de langage artificiel, donc je n'ai pas d'état d'esprit ou d'émotions comme les humains. Je suis juste là pour discuter et répondre à vos questions ! Comment puis-je vous aider aujourd'hui ?'''''<nowiki>"}}],"usage":{"prompt_tokens":19,"completion_tokens":58,"total_tokens":77}</nowiki> | |||

Plus d'explications ici : https://localai.io/features/text-generation/ | |||

=== | ===== Génération d'images ===== | ||

Le générateur d'image par défaut est limité au 512x512px max. | |||

Exemple : | Exemple : | ||

$ podman pull '''docker.io/localai/localai:latest-aio-cpu''' | $ curl http://'''<IP-Machine>''':'''8082'''/v1/images/generations -H "Content-Type: application/json" -d '{ | ||

"prompt": "'''A cute baby sea otter'''", | |||

"size": "'''256x256'''" | |||

}' | |||

Retourne : | |||

{"created":'''1724418751''',"id":"xxxxxxx-c8d9-xxxxx-909b-xxxxxxx","data":[{"embedding":null,"index":0,"url":"http://'''<IP-Machine>''':'''8082'''/generated-images/'''b641977059781'''<nowiki>.png"}], | |||

"usage":{"prompt_tokens":0,"completion_tokens":0,"total_tokens":0}}</nowiki> | |||

[[Fichier:ImageiA.png|600px|centré|vignette]] | |||

Plus d'explications ici : https://localai.io/features/image-generation/ | |||

===== TTS ===== | |||

Pour transcrire du texte en Audio (il est possible que <cmd>curl</cmd> puisse avoir besoin d'avoir l'option ''output'' pour créer la sortie vers un fichier par exemple) | |||

$ curl http://'''<IP-Machine>''':'''8082'''/tts -H "Content-Type: application/json" -d '{ | |||

"input": "'''Hello world'''", | |||

"model": "tts-1" | |||

}' | |||

Plus d'explications ici : https://localai.io/features/text-to-audio/ | |||

===== Talk ===== | |||

<code>$ curl http://'''<IP-Machine>''':'''8082'''/v1/audio/transcriptions -H "Content-Type: multipart/form-data" -F file="@<FILE_PATH>" -F model="<MODEL_NAME>"</code> | |||

Plus d'explications ici : https://localai.io/features/audio-to-text/ | |||

===== GPT Vision ===== | |||

Permet de décrire une image (à confirmer pour une vidéo et autres ?) : | |||

Exemple avec le modèle "'''gpt-4-vision-preview'''" (d'autres sont à installer) : | |||

curl http://'''<IP-Machine>:8082'''/v1/chat/completions -H "Content-Type: application/json" -d '{ | |||

"model": "'''gpt-4-vision-preview'''", | |||

"messages": [{"role": "user", "content": [{"type":"text", "text": "'''What is in the image?'''"}, {"type": "image_url", "image_url": {"url": "'''<nowiki>https://upload.wikimedia.org/wikipedia/commons/thumb/d/dd/Gfp-wisconsin-madison-the-nature-boardwalk.jpg/2560px-Gfp-wisconsin-madison-the-nature-boardwalk.jpg</nowiki>'''<nowiki>" }}], "temperature": 0.9}]}'</nowiki> | |||

{"created":'''1724576857''',"object":"chat.completion","id":"'''xxxx-xxxx-xxxxx-xxxx-xxxxxx'''","model":"'''gpt-4-vision-preview'''","choices":[{"index":0,"finish_reason":"stop","message":{"role":"assistant","content":"'''The image features a wooden path or boardwalk that is surrounded by tall grass, flowers, and weeds on both sides. The boardwalk is located in a rural marsh or grassy plain, with clouds visible in the sky above.'''<nowiki>\u003c/s\u003e"}}],"usage":{"prompt_tokens":1,"completion_tokens":49,"total_tokens":50}}</nowiki> | |||

Plus d'explications ici : https://localai.io/features/gpt-vision/ | |||

===== Avec Nextcloud ===== | |||

===== Installation des applications nécessaires ===== | |||

Celles-ci sont disponibles sur la boutique <app>Nextcloud</app> : | |||

* Intégration -> Nextcloud Assistant | |||

* Intégration -> OpenAI and LocalAI integration | |||

===== Configurations ===== | |||

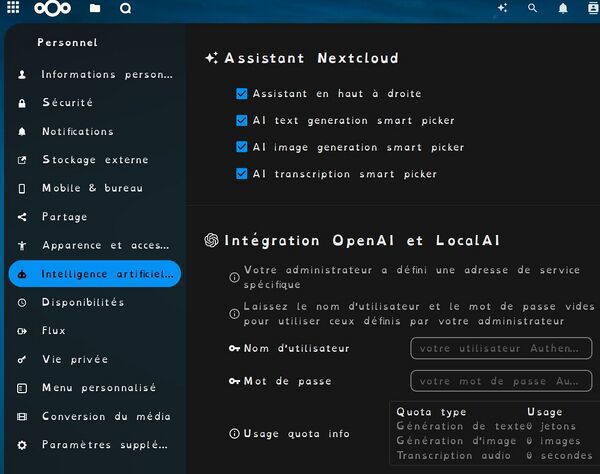

====== Coté Personnel ====== | |||

Dans "'''Paramètres d'administration'''" -> "'''Intelligence artificielle'''" activer ou non les options disponibles : | |||

[[Fichier:Copie d'écran 20240825 102732.jpg|600px|centré|vignette]] | |||

====== Coté Administration ====== | |||

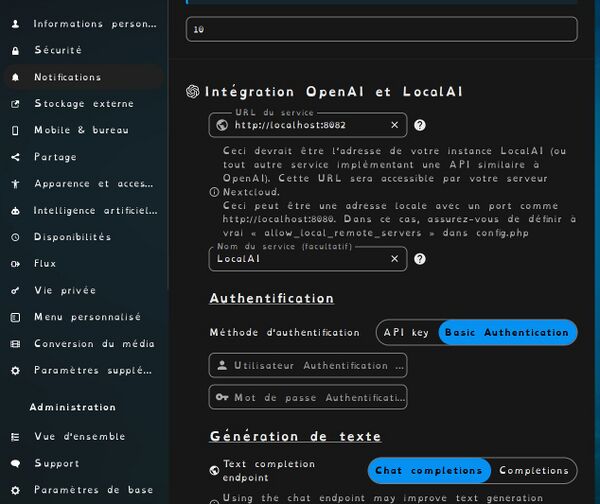

Dans "'''Paramètres d'administration'''" -> "'''Administration'''" -> "'''Intelligence artificielle'''"->"'''Intégration OpenAI et LocalAI'''" | |||

Rentrer l'URL de votre service IA (ici '''localhost''', n'oublier pas de rajouter la condition <cmd>allow_local_remote_servers</cmd> à <cmd>true</cmd> dans votre fichier de de configuration de <app>Nextcloud</app> <cmd>config.php</cmd>) : | |||

[[Fichier:Copie d'écran 20240825 104709.jpg|600px|centré|vignette]] | |||

''A savoir qu'il y avait une option pour définir le modèle à utiliser. Mais cela semble avoir disparu... Sans doute qu'ils vont rajouter le choix selon ce que l'on cherche à faire, tchat/traducteur, générateur d'images, texte vers voix/voix vers texte, etc).'' | |||

=== Mise à jour des images === | |||

Toutes les notes des mises à jour sont disponibles ici https://github.com/mudler/LocalAI/releases . | |||

Il suffit simplement de supprimer l'instance en cours et de refaire un "pull" de l'image puis de relancer notre container. | |||

===== Suppression ===== | |||

$ podman rm -f '''test''' | |||

===== Mise à jour de l'image ===== | |||

$ podman pull '''docker.io/localai/localai:latest-aio-cpu''' | |||

===== Relance du container ===== | |||

$ podman run -d --security-opt label=disable -p '''8082''':8080 -p '''3333''':3333 -e GRPC_PORT='''3333''' -e MODELS_PATH=/build/models -v '''~/projets/IA/models:/build/models''' -e LOCALAI_THREADS='''6''' -e LOCALAI_CONTEXT_SIZE='''2048''' -e LOCALAI_UPLOAD_LIMIT='''100''' --name '''test''' docker.io/localai/localai:latest-aio-cpu | |||

=== Pour aller plus loin | === Pour aller plus loin === | ||

== Conseils == | == Conseils == | ||

Voici une liste de quelques conseils à suivre pour que expérience se passe bien. | Voici une liste de quelques conseils à suivre pour que l'expérience se passe bien ('''à étoffer'''). | ||

# Ne surtout pas oublier que '''vous êtes responsables''' dans tous les cas de figure. Que ce soit généré par IA ou non ! | |||

# Ne jamais croire à une fiabilité à 100% sans vérification par d'autres sources ! | |||

# Bien se dire que c'est considéré comme une "'''AIDE'''" et non pas comme une solution de remplacement ! | |||

# Il faut bien choisir son modèle selon le besoin sachant que : | |||

## Certains demandent beaucoup de puissance machines (Exemple : llma3-70b-instruct) | |||

## Qu'il y en a des censurés et non censurés (à vos risques et périls) | |||

## Certains sont uniquement adaptés à un type de besoin bien particulier | |||

## Utiliser les "'''API'''" et la ligne de commande si vous voulez aller plus loin que ce que propose l'interface | |||

# Ne pas hésitez à : | |||

## Relire les réponses et corriger si besoin (conseil un peu trop souvent oublié même chez les "PRO") | |||

## Vérifiez le rendu des images | |||

### Affiner les paramètres de la demande | |||

### Ne pas hésiter à retoucher | |||

## Vérifiez la cohérence Texte/Audio et Audio/Texte | |||

[[Catégorie:Rédaction en cours]] | [[Catégorie:Rédaction en cours]] | ||

[[Catégorie:Réseaux et Serveurs]] | [[Catégorie:Réseaux et Serveurs]] | ||

Version du 7 septembre 2024 à 19:27

Article en cours de rédaction ou de modification !

Le présent article est actuellement en cours de rédaction ou de modification.

Adressez-vous à la personne en charge pour toute proposition ou modification.

| Aide Pour lire ce wiki convenablement, merci de lire la page suivante concernant les conventions de nommage. |

Introduction

Je vais vous présenter l'installation d'une instance pour bénéficier d'un assistant personnel basé sur des modèles neuronaux libres ou avec quelques conditions en local.

Pour cela nous utiliserons LocalAI qui est une API REST alternative open source à OpenAI : https://localai.io/

Vous pouvez déployer la solution directement sur votre système, dans un container Podman/Docker ou sur un cluster Kubernetes.

Cette documentation s'attardera à présenter une installation dans des containers avec Podman : https://podman.io/

Cela parle aussi de l'intégration avec votre serveur Nextcloud à partir de la version Hub 8 (29.x) : https://nextcloud.com/fr/

Nous n'utiliserons qu'une seule instance sur un simple nœud (1 machine physique ou virtuelle), mais il est possible d'en utiliser plusieurs pour du calcul en parallèle.

Présentation

LocalAI permet d'avoir une solution locale pour la mise à disposition et l’exploitation de modèles d’Intelligence Artificielle (IA ou AI en anglais) en local (pas de connexion Internet possible), généralement libre et/ou avec quelques conditions.

Parmi les modèles et options proposés vous pouvez disposer :

- De tchats (Conversationnels + Traducteurs multi-lingues)

- De générateurs d'Images

- De convertisseurs Vidéo/Musique vers du Texte

- De convertisseurs Texte vers Voix

- Et bien d'autres possibilités présentes et à venir...

Pré-Requis

Nous vous conseillons de bien régler les paramètres de votre bios et de ne pas utiliser les modes d'overclocking automatique, ainsi que les modes de "boost" du processeur, ainsi que de la carte graphique. Les performances ne sont pas trop impactées et vous allez gagner en consommation/température, mais aussi en silence de fonctionnement.

N'hésitez pas à demander de l'aide sur notre forum si nécessaire.

Au minimum

- Processeur 4 cœurs/4 threads

- Un bon refroidissement

- 16 Go de Mémoire (RAM)

- 100 Go de stockage disponible (les modèles prennent beaucoup de place)

Conseillé

- Processeur 6 cœurs/12 threads

- 32, voire 64 Go de Mémoire (RAM)

- 500 Go de stockage (NVME de préférence)

En option

- Carte graphique supportant le GPGPU avec CUDA (Nvidia), ROCM (AMD), SYCL (INTEL)

- Un NPU

- Autres à suivre

Podman

Installation

Accélération CPU (réalisé et testé sur AMD Ryzen ZEN3 5600G et 5800X)

On ouvrira les flux du pare-feu pour les accès distants sur les ports 8082/TCP et 3333/TCP :

# firewall-cmd --add-port=8082/tcp --add-port=3333/tcp && firewall-cmd --runtime-to-permanent

On installe podman si ce n'est pas déjà fait :

# dnf install podman

On récupère le container de localai pour processeur :

$ podman pull docker.io/localai/localai:latest-aio-cpu

On va créer un répertoire de stockage permanent (à modifier au besoin) :

$ mkdir ~/projets/IA/models

On va lui attribuer l'étiquette SELinux du dossier /var/lib/containers (à revoir, car cela ne rend pas le dossier accessible pour les containers sur Fedora 40...) :

$ sudo semanage fcontext -a -e /var/lib/containers /home/UTILISATEUR/projets/IA/models

On lance notre container :

$ podman run -d --security-opt label=disable -p 8082:8080 -p 3333:3333 -e GRPC_PORT=3333 -e MODELS_PATH=/build/models -v ~/projets/IA/models:/build/models -e LOCALAI_THREADS=6 -e LOCALAI_CONTEXT_SIZE=2048 -e LOCALAI_UPLOAD_LIMIT=100 --name test docker.io/localai/localai:latest-aio-cpu

Descriptif des options à modifier au besoin :

- LOCALAI_THREADS : Indique le nombre de cœurs/threads à utiliser (de préférence n'utiliser que des cœurs physique). Ici pour un Ryzen 5 en 6 cœurs/12 threads (4 threads par défaut)

- LOCALAI_CONTEXT_SIZE (en Méga octets) : Définit la taille du contexte des modèles (512 Mo par défaut). Ici réglé sur 2048 Mo

- LOCALAI_UPLOAD_LIMIT (en Méga octets) : Limite de téléchargement (15 Mo par défaut). Ici réglé sur 100 Mo

Accélération CPU+GPU ROCM (AMD)

A venir

Accélération CPU+GPU CUDA (NVIDIA)

A venir

Accélération CPU+GPU SYCL (INTEL)

A venir

Utilisation

Par l'interface graphique Web

Pour accéder à l'interface graphique depuis un navigateur Web, il faut utiliser le lien :

http://<IPmachine>:8082

ou

http://localhost:8082

Il est nécessaire de bien sélectionner son modèle avant de l'utiliser (exemple : génération d'image avec "stable diffusion", etc)

Accueil

Models

La liste des modèles peut être consultée (en anglais) soit sur cette page, soit sur le site : https://localai.io/gallery.html .

Vous en avez beaucoup de disponibles, censurées ou non. Il faut consulter le descriptif en anglais pour savoir si cela vous convient.

Il y en a d'autres à installer manuellement, voir pour cela sur le site de LocalAI.

Chat

Il faut choisir le modèle pour pouvoir converser avec ; la liste ne fait pas la distinction.

Exemple de modèles "GPT4" (par défaut) ou llama3-8b-instruct (à installer, bon rapport performance/qualité dans les interactions).

Generate images

TTS

Talk

</>API

En ligne de commande

Voici quelques exemples et résultats selon les cas d'utilisation. Les exemples sont généralement tirés de ceux de "localAI" avec les liens directs.

La liste des modèles installés disponibles s'obtient avec :

$ curl http://<IP-Machine>:8082/v1/models

Chat

Exemple :

$ curl http://<IP-Machine>:8082/v1/chat/completions -H "Content-Type: application/json" -d '{

"model": "llama3-8b-instruct",

"messages": [{"role": "user", "content": "Salut, comment vas tu?"}],

"temperature": 0.1

}'

Réponse :

{"created":1720598309,"object":"chat.completion","id":"xxxxxxx-a24f-xxxxxxx-a0de-xxxxxxxxxdeb","model":"llama3-8b-instruct","choices":[{"index":0,"finish_reason":"stop","message":{"role":"assistant","content":"Bonjour ! Je suis un modèle de langage artificiel, donc je n'ai pas d'état d'esprit ou d'émotions comme les humains. Je suis juste là pour discuter et répondre à vos questions ! Comment puis-je vous aider aujourd'hui ?"}}],"usage":{"prompt_tokens":19,"completion_tokens":58,"total_tokens":77}

Plus d'explications ici : https://localai.io/features/text-generation/

Génération d'images

Le générateur d'image par défaut est limité au 512x512px max.

Exemple :

$ curl http://<IP-Machine>:8082/v1/images/generations -H "Content-Type: application/json" -d '{

"prompt": "A cute baby sea otter",

"size": "256x256"

}'

Retourne :

{"created":1724418751,"id":"xxxxxxx-c8d9-xxxxx-909b-xxxxxxx","data":[{"embedding":null,"index":0,"url":"http://<IP-Machine>:8082/generated-images/b641977059781.png"}],

"usage":{"prompt_tokens":0,"completion_tokens":0,"total_tokens":0}}

Plus d'explications ici : https://localai.io/features/image-generation/

TTS

Pour transcrire du texte en Audio (il est possible que curl puisse avoir besoin d'avoir l'option output pour créer la sortie vers un fichier par exemple)

$ curl http://<IP-Machine>:8082/tts -H "Content-Type: application/json" -d '{

"input": "Hello world",

"model": "tts-1"

}'

Plus d'explications ici : https://localai.io/features/text-to-audio/

Talk

$ curl http://<IP-Machine>:8082/v1/audio/transcriptions -H "Content-Type: multipart/form-data" -F file="@<FILE_PATH>" -F model="<MODEL_NAME>"

Plus d'explications ici : https://localai.io/features/audio-to-text/

GPT Vision

Permet de décrire une image (à confirmer pour une vidéo et autres ?) :

Exemple avec le modèle "gpt-4-vision-preview" (d'autres sont à installer) :

curl http://<IP-Machine>:8082/v1/chat/completions -H "Content-Type: application/json" -d '{

"model": "gpt-4-vision-preview",

"messages": [{"role": "user", "content": [{"type":"text", "text": "What is in the image?"}, {"type": "image_url", "image_url": {"url": "https://upload.wikimedia.org/wikipedia/commons/thumb/d/dd/Gfp-wisconsin-madison-the-nature-boardwalk.jpg/2560px-Gfp-wisconsin-madison-the-nature-boardwalk.jpg" }}], "temperature": 0.9}]}'

{"created":1724576857,"object":"chat.completion","id":"xxxx-xxxx-xxxxx-xxxx-xxxxxx","model":"gpt-4-vision-preview","choices":[{"index":0,"finish_reason":"stop","message":{"role":"assistant","content":"The image features a wooden path or boardwalk that is surrounded by tall grass, flowers, and weeds on both sides. The boardwalk is located in a rural marsh or grassy plain, with clouds visible in the sky above.\u003c/s\u003e"}}],"usage":{"prompt_tokens":1,"completion_tokens":49,"total_tokens":50}}

Plus d'explications ici : https://localai.io/features/gpt-vision/

Avec Nextcloud

Installation des applications nécessaires

Celles-ci sont disponibles sur la boutique Nextcloud :

- Intégration -> Nextcloud Assistant

- Intégration -> OpenAI and LocalAI integration

Configurations

Coté Personnel

Dans "Paramètres d'administration" -> "Intelligence artificielle" activer ou non les options disponibles :

Coté Administration

Dans "Paramètres d'administration" -> "Administration" -> "Intelligence artificielle"->"Intégration OpenAI et LocalAI"

Rentrer l'URL de votre service IA (ici localhost, n'oublier pas de rajouter la condition allow_local_remote_servers à true dans votre fichier de de configuration de Nextcloud config.php) :

A savoir qu'il y avait une option pour définir le modèle à utiliser. Mais cela semble avoir disparu... Sans doute qu'ils vont rajouter le choix selon ce que l'on cherche à faire, tchat/traducteur, générateur d'images, texte vers voix/voix vers texte, etc).

Mise à jour des images

Toutes les notes des mises à jour sont disponibles ici https://github.com/mudler/LocalAI/releases .

Il suffit simplement de supprimer l'instance en cours et de refaire un "pull" de l'image puis de relancer notre container.

Suppression

$ podman rm -f test

Mise à jour de l'image

$ podman pull docker.io/localai/localai:latest-aio-cpu

Relance du container

$ podman run -d --security-opt label=disable -p 8082:8080 -p 3333:3333 -e GRPC_PORT=3333 -e MODELS_PATH=/build/models -v ~/projets/IA/models:/build/models -e LOCALAI_THREADS=6 -e LOCALAI_CONTEXT_SIZE=2048 -e LOCALAI_UPLOAD_LIMIT=100 --name test docker.io/localai/localai:latest-aio-cpu

Pour aller plus loin

Conseils

Voici une liste de quelques conseils à suivre pour que l'expérience se passe bien (à étoffer).

- Ne surtout pas oublier que vous êtes responsables dans tous les cas de figure. Que ce soit généré par IA ou non !

- Ne jamais croire à une fiabilité à 100% sans vérification par d'autres sources !

- Bien se dire que c'est considéré comme une "AIDE" et non pas comme une solution de remplacement !

- Il faut bien choisir son modèle selon le besoin sachant que :

- Certains demandent beaucoup de puissance machines (Exemple : llma3-70b-instruct)

- Qu'il y en a des censurés et non censurés (à vos risques et périls)

- Certains sont uniquement adaptés à un type de besoin bien particulier

- Utiliser les "API" et la ligne de commande si vous voulez aller plus loin que ce que propose l'interface

- Ne pas hésitez à :

- Relire les réponses et corriger si besoin (conseil un peu trop souvent oublié même chez les "PRO")

- Vérifiez le rendu des images

- Affiner les paramètres de la demande

- Ne pas hésiter à retoucher

- Vérifiez la cohérence Texte/Audio et Audio/Texte